大模型部署文档

vllm部署

1.版本信息

操作系统:linux-ubuntu

python版本:3.9 - 3.12

CUDA版本:12.0

2.配置环境

安装驱动前一定要更新软件列表和安装必要软件、依赖。

sudo apt-get upodate

sudo apt-get instgall g++

sudo apt-get install gcc

sudo apt-get install make

3.1安装CUDA

进入NVIDIA CUDA 版本列表页面,下载最新版本即刻。

https://developer.nvidia.com/cuda-toolkit-archive

进入版本的下载页面,选择对应的操作系统、架构、操作系统、版本,安装方式,就可以看到相应的安装命令

安装conda

可以用wget直接下载下来 wget <url>

https://www.anaconda.com/download/success

下载下来后执行安装程序:bash ~/Anaconda3-20xx.xx-Linux-x86_64.sh

按照提示操作,注意最后一步当安装程序询问你是否需要初始化Anaconda时,输入yes并回车来初始化Anaconda

3.3 创建环境并安装依赖

创建一个基于python3.12的conda环境

conda create --name vllm python=3.11

--name后面的就是环境的名字,这里是vllm。后面的3.12指定了python版本是3.12。

切换到刚创建的虚拟环境中:conda activate vllm

3.4 安装vllm

切换到国内镜像源进行安装

pip install -i https://pypi.tuna.tsinghua.edu.cn/simple vllm

*dify部署*

dify文档里最推荐的是基于Docker部署。所以需要先安装Docker环境。

1.安装docker

docker官网上有各个操作系统的详细安装说明,这里以Ubuntu为例,首先需要更新APT,然后安装Docker官方GPG KEY:

sudo apt-get update

sudo apt-get install ca-certificates curl

sudo install -m 0755 -d /etc/apt/keyrings

sudo curl -fsSL https://download.docker.com/linux/ubuntu/gpg -o /etc/apt/keyrings/ docker.asc

sudo chmod a+r /etc/apt/keyrings/docker.asc

接着,添加官方存储库并更新源数据:

echo \

\"deb [arch=\$(dpkg --print-architecture) signed-by=/etc/apt/keyrings/docker.asc] https://download.docker.com/linux/ubuntu \

\$(. /etc/os-release && echo \"\$VERSION_CODENAME\") stable\" | \

sudo tee /etc/apt/sources.list.d/docker.list > /dev/null

sudo apt-get update

直接安装Docker和docker-compose:

sudo apt-get install docker-ce docker-ce-cli containerd.io docker-buildx-plugin docker-compose-plugin

国内环境直接从宝塔社区下载模型,国外从hugging face下载模型

宝塔:https://www.modelscope.cn/home

Hugging face :https://huggingface.co/

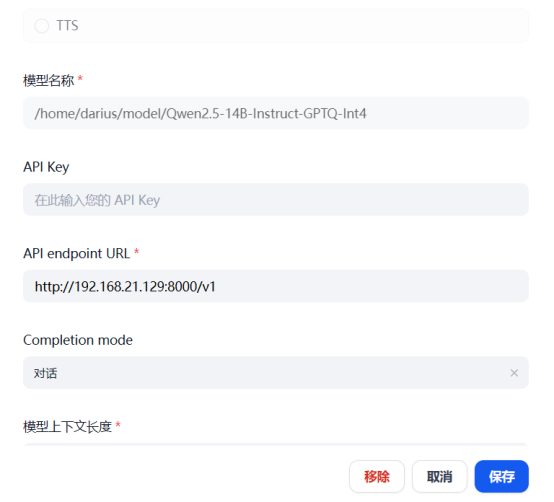

这里用的模型是Qwen2.5-14B-Instruct-GPTQ-Int4

vllm serve /home/darius/model/Qwen2.5-14B-Instruct-GPTQ-Int4

vllm默认端口是8000

netstat -ltump 查看8000端口信息

vllm部署大模型成功

2.安装dify

先找一个空文件夹,将dify源码拉取下来:

git clone https://github.com/langgenius/dify.git

如果你的服务器上没有git,可以使用以下命令安装它:

sudo apt-get install git

进入 dify 源代码的 docker 目录,执行一键启动命令:

cd dify/docker

docker compose up -d

如果拉取失败应该更换国内的docker镜像源

sudo nano /etc/docker/daemon.json

\"registry-mirrors\": [

\"https://docker.1panel.live",

\"https://docker.m.daocloud.io",

]

重新加载docker镜像文件和重启docker服务

sudo systemctl daemon-reload

sudo restart docker

再次进行docker镜像拉取

sudo docker compose up -d

检查是否所有容器都正常运行:

docker compose ps

接下来,你便可以通过服务器浏览器访问http://IP:80来访问dify了。

进入后设置管理员账户

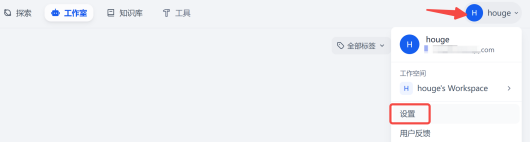

点击右上角个人头像-设置

在设置里找到 模型供应商 找到OpenAI-API-compatible

填写好信息后点击保存

注意API要加上/v1后缀

到此大模型私有化部署完成

附:vllm 常用启动命令参数

--tensor-parallel-size 8: 使用8个GPU进行张量并行计算。

--trust-remote-code 运行的时候信任该模型。

--max-model-len 30000 上下文文本长度。

--gpu-memory-utilization 0.98: GPU内存利用率设置为98%。

--max-model-len 3072: 模型最大输入长度为3072个token。

--max-num-batched-tokens 4096: 批处理最大token数为4096。

--max-num-seqs 16: 最大并发序列数为16。

--port 8000: API服务运行在8000端口。

--swap-space 100: 设置100GB的交换空间。

--enforce-eager: 强制使用eager模式运行。